苹果最近发布了一种新的研究,它展示了一个名为 Ferret-UI 的语言模型,能够深入理解屏幕上的内容。这项研究将有助于改进人机交互系统,并可能对其他应用程序和设备产生影响。

最近,苹果发表了一篇研究论文,展示了一种多模态大语言模型,命名为“Ferret-UI”。

根据论文介绍,针对MLLMs模型(多模态大语言模型)无法有效理解移动应用在屏幕上显示的内容的问题,对Ferret-UI模型进行了调整。

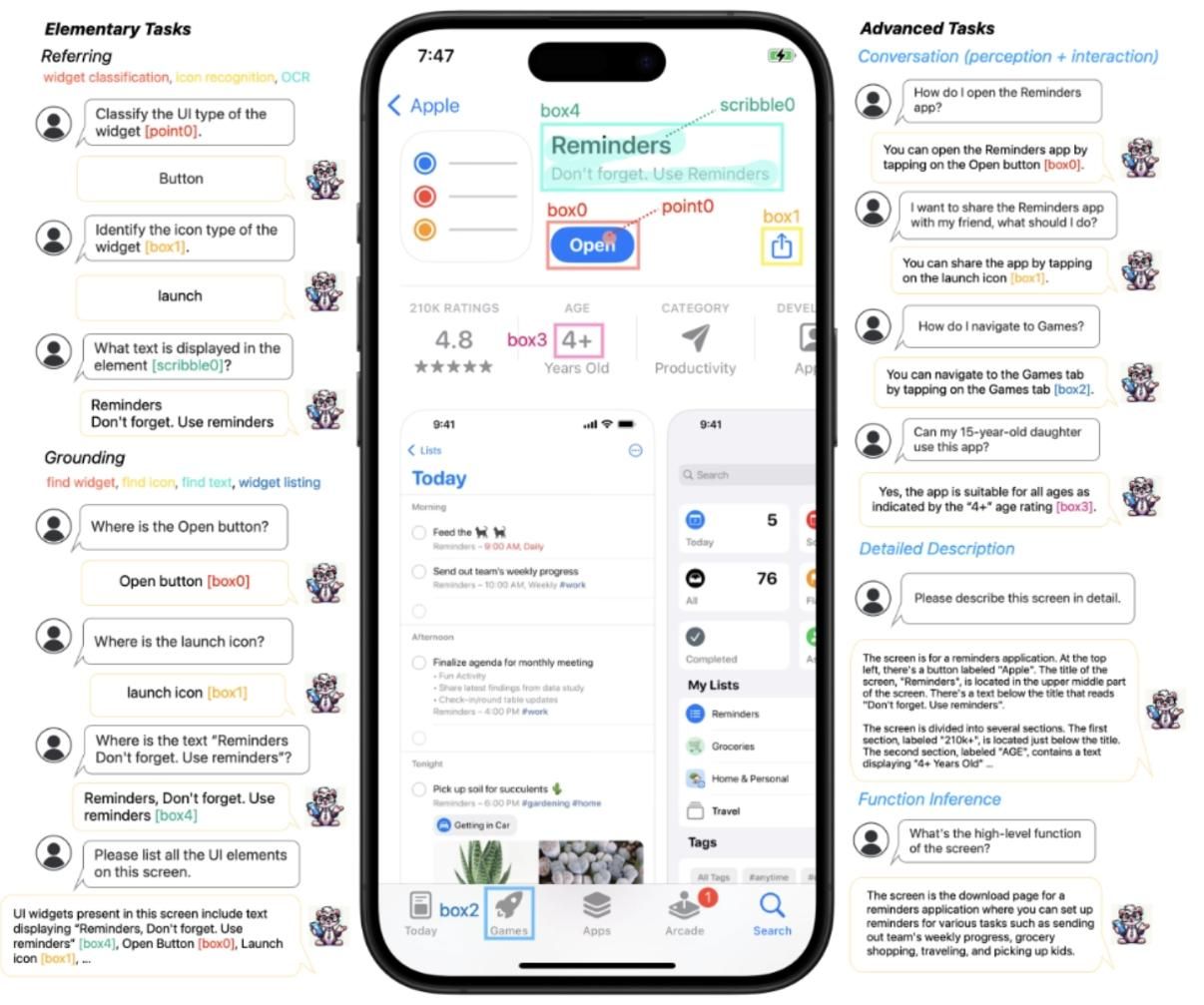

为了训练Ferret-UI,苹果收集了大量初级用户界面任务的训练样本,如图标识别、文本搜索和widget列表。

这些样本的格式都是根据带有地域注释的说明书设计的,便于准确参考和接地气。

同时,为了增强模型的推理能力,苹果进一步编制了高级任务数据集,包括详细描述、感知/交互对话和功能推理。

这使得Ferret-UI在理解应用程序在屏幕上显示的内容方面,与目前的GPT-4V等MLLMs机型相比,具有明显的优势。

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。