本文讨论了强化学习(RL)与神经网络(NN)在移动设备上发挥重要作用的可能性。强化学习可以让AI自主地调整策略来达到最优结果,而NN则可以处理大量复杂的数据。强化NPU可以在终端侧为AI模型提供高效的计算能力,实现更加灵活和便捷的训练。本文还探讨了异构计算的重要性,它可以帮助提高AI的性能并降低能耗。通过充分利用强化NPU和异构计算的优势,我们可以期待更加强大的AI技术。

生成式人工智能的时代已经到来。我们都可以看到生成式人工智能技术在手机、个人电脑和电动汽车上的应用。高通新推出的第三代骁龙8移动平台和骁龙X Elite平台都更加强调AI的性能和表现。

近日,泡泡网参加了与高通技术公司产品管理高级副总裁Ziad Asghar的交流活动,期间Ziad Asghar详细介绍了高通在AI方面的优势。

异构计算带来更好的生成式人工智能体验。

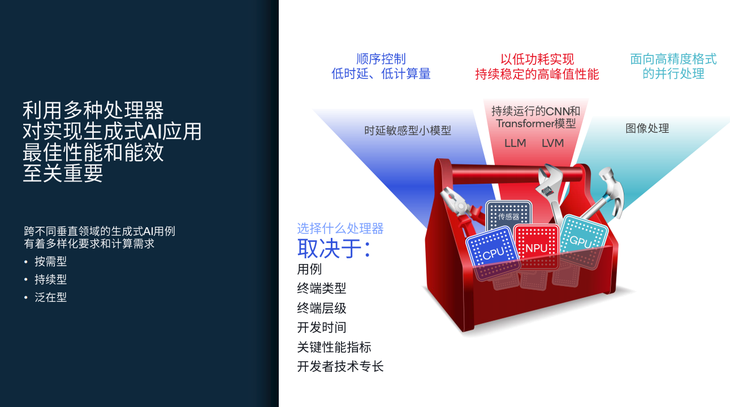

生成式人工智能的多样化要求也带来了计算的多样性,这是单个处理器无法实现的。因此,异构计算体系结构成为一种新的选择。异构计算架构可以充分发挥多处理器的优势。CPU擅长顺序控制和即时性,GPU适合并行数据流处理,NPU擅长标量、向量和张量数学运算,可用于核心AI工作负载。

异构计算可以实现更好的应用性能、能效和电池寿命,从而最大限度地提升生成式人工智能最终用户体验。

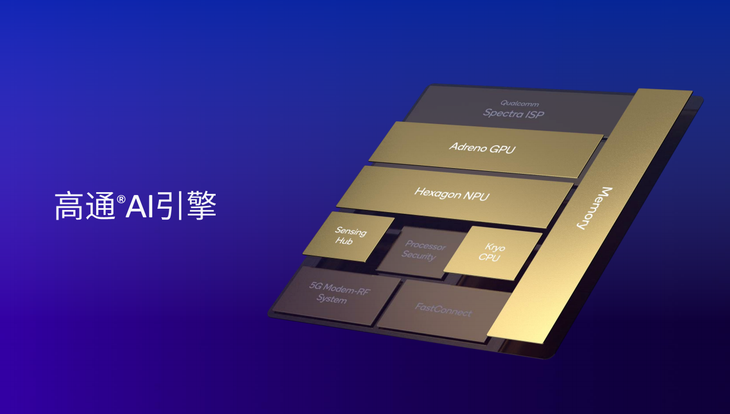

针对异构计算架构,高通构建了高通AI引擎、高通Hexagon NPU、高通Adreno GPU、高通Kryo或高通Oryon CPU、高通传感器中枢和内存子系统。高通AI引擎可以跨所有处理器组件进行选择,从而充分发挥产品性能。

高通AI引擎中,Adreno GPU由高通自主打造,每瓦性能领先业界。Hexagon NPU还具有强大的差异化优势和业界领先的AI处理能力。

同时,记忆力的重要性也不容忽视。在生产AI用例中,芯片需要通过内存读取大模型并进行处理。第三代骁龙8和其他高通产品已支持业界最先进的LPDDR5x内存,频率高达4.8GHz,可支持以极高的芯片内存读取速度运行百川、骆马2等大型语言模型,实现极快的令牌生成速率和领先的用户体验。

具体工作上,CPU擅长顺序控制,非常适合要求低延迟的应用场景。CPU也适用于相对较小的传统模型,如卷积神经网络模型(CNN)或一些特定的大型语言模型(LLM)。GPU主要擅长高精度格式的并行处理,比如对质量要求非常高的图像和视频处理。

在AI计算中,NPU的作用更加重要,高通制造的NPU具有业界领先的性能功耗比,尤其是在连续使用的情况下,需要在低功耗的情况下实现持续稳定的峰值性能,NPU可以发挥其最大的优势。在基于LLM和大型视觉模型(LVM)的不同用例中,如稳定扩散或其他扩散模型,NPU具有出色的性能功耗比。

此外,高通传感器中心可以以非常低的功耗运行始终在线的用例。通过将低功耗AI能力集成到芯片子系统中,芯片可以在终端侧获取大量的情境信息,为用户带来个性化的生成式人工智能体验。这也是终端侧AI的优势之一。传感器hub获取的信息会保留在终端上,不会上传到云端,既能给用户带来个性化的生成式人工智能体验,又能保证与用户相关的信息安全。

Hexagon NPU带来领先的大预测模型处理能力。

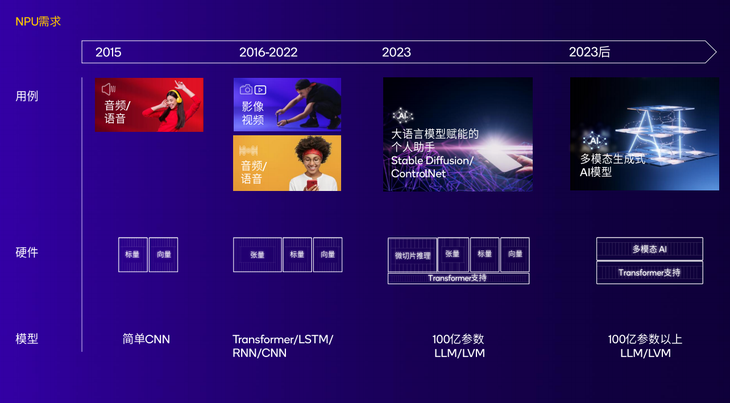

早在2015年,高通就推出了第一代AI引擎,其中NPU集成了标量和矢量运算扩展,主要面向包括音频和语音处理的卷积神经网络模型(CNN)和长短期记忆网络模型(LSTM),以期为用户带来出色的音频/语音体验。

2016年至2022年,高通对NPU的能力进行了改进,为NPU增加了张量核,并引入了变压器层处理,让NPU参与到更多的应用场景中。在音频和语音的基础上,增加了增强图像的能力,如暗光拍照、去噪、支持多帧处理技术等。

2023年。NPU的能力大大增强。高通在NPU中添加了Transformer支持,以更好地处理基于Transformer的模型,这使得Hexagon NPU能够支持LLM和LVM。高通还认为,Transformer架构将继续用于即将推出的许多新车型。

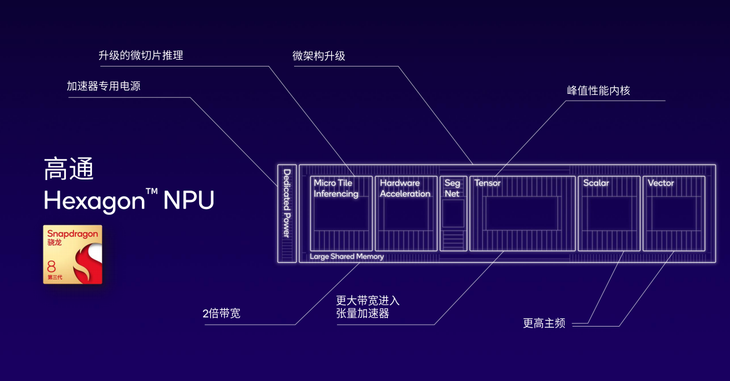

Hexagon NPU在终端侧可以运行多达100亿个参数的模型,无论是生成首个令牌的速度,还是每秒生成令牌的速度,都处于业界领先水平。高通还引入了微切片推理技术,并增加了可支持所有引擎组件的大共享内存,从而实现领先的LLM处理能力。

在Hexagon NPU的帮助下,第三代骁龙8移动平台的AI能力得到了进一步加强。在MWC2024期间,高通展示了第一个运行在第三代骁龙8移动平台上的大型语言和视觉助理模型(LLaVA),该模型可以基于图像输入回答用户的相关问题。

同时,基于骁龙X Elite,高通还展示了全球首个运行在终端侧的大规模多模态语言模型(LMM),参数超过70亿,可接受文本和音频输入(如音乐、交通环境音频等。)并基于音频内容生成多轮对话。

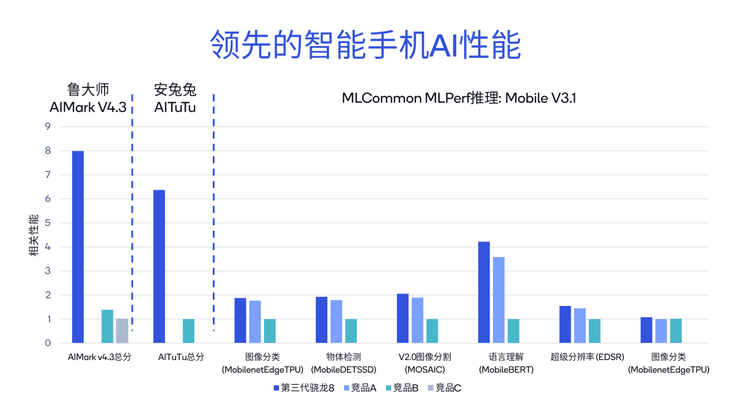

具体性能方面,第三代骁龙8在Android和iOS平台与三款竞品进行对比。在鲁大师的AIMark V4.3基准测试中,第三代骁龙8的总成绩分别是竞品B的5.7倍和竞品C的7.9倍。在安兔兔的艾图图基准测试中,第三代骁龙8的总成绩是竞品b的6.3倍,在MLCommon MLPerf推理的不同分项中,如图像分类、语言理解、超分辨率,性能保持领先。

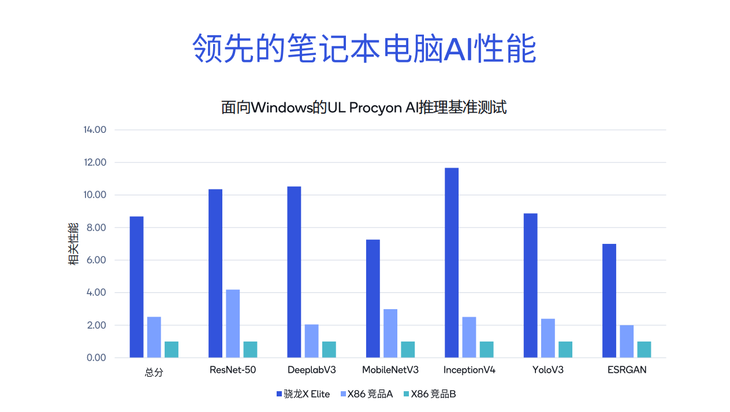

在PC端AI性能方面,骁龙X Elite与其他X86架构竞争对手进行了比较。在UL Procyon AI reasoning benchmark test for Windows中,骁龙X Elite在ResNet-50、DeeplabV3等测试中保持大幅领先,基准测试总分分别是X86架构竞争对手A的3.4倍和竞争对手B的8.6倍。

得益于其强大的AI能力,骁龙X Elite可以为用户提供比其他解决方案更好的体验,无论是运行微软Copilot还是在PC上生成文档摘要和文档写作等AI应用。

推动AI发展,为开发者提供便利

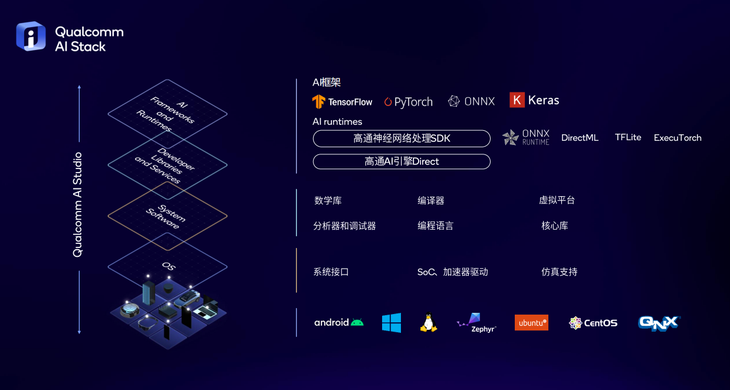

AI行业的发展离不开开发者的支持。为了帮助开发者更好地构建AI相关的应用,高通还提供了完善的开发工具,并创建了高通AI Stack Stack。

高通AI软件栈支持目前所有主流AI框架,包括TensorFlow、PyTorch、ONNX、Keras;它还支持所有主流的AI运行时,包括DirectML,TFLite,ONNX运行时,ExecuTorch,以及不同的编译器和数学库等AI工具。

基于高通AI软件栈,开发者可以通过一次开发将软件应用于高通所有不同的产品线,从智能手机到PC、物联网终端、汽车等,提高了开发效率。

同时,高通还在MWC 2024期间推出了全新的高通人工智能中心,这是一个供开发者获取开发资源的中心。开发者可以基于骁龙或高通平台构建人工智能应用。高通AI Hub为开发者提供全面优化的AI模型库,包括传统AI模型和生成式人工智能模型,可以部署在骁龙和高通的平台上。

在使用高通AI Hub时,开发者可以选择所需的大型模型。高通人工智能中心将支持超过75个人工智能模型,包括传统的人工智能模型和生成式人工智能模型。比如百川-7B,然后你可以选择用来开发应用的框架,比如Pytorch,Tensorflow。接下来,开发者可以选择相应的目标平台,可以是某款手机,也可以是高通平台的特定型号。在确认上述信息后,高通AI Hub可以为开发者提供针对其指定应用和平台的优化模型。开发人员只需要几行代码就可以获得模型并将其集成到应用程序中。

最后

高通技术公司产品管理高级副总裁Ziad Asghar提到,随着生成式人工智能用例的扩展,模型的规模越来越大,用户的规模也会增加,云处理的成本会限制生成式人工智能的发展。在终端端运行AI模型有巨大的成本优势。

终端侧AI也具有重要的可持续性优势。大规模用户接入云模式会产生大量的能耗。在云端运行这些AI模型,GPU功耗可达数百瓦,散热需要大量水资源。在终端侧运行大型模型具有显著的能效优势。

目前,高通的技术可以支持AI模型在终端侧以更高效的方式运行,真正将这些优秀的用例带给消费者。